Renderizar Objetos sintéticos en una fotografía

Estos días me he encontrado con un interesante trabajo realizado por unos estudiantes de la Universidad de Illinois. La idea les vino inspirados en el método ya conocido de Debevec, en el que se usa una imagen HDRI para obtener la información de luz para que un objeto en 3D se pueda iluminar con la misma iluminación que hay en el lugar donde se tomó la fotografía. En éste caso se puede usar cualquier fotografía para obtener esa información. Éste tipo de imagen, la normal, también se denomina LDR (Low Dinamic Range).

Según ellos explican en su PDF, encontraban este método, aunque con muy buenos resultados, un poco laborioso:

- Obtención de la imagen HDRI con varias fotografías con diferente exposición.

- Creación de un mapa de entorno.

- Modelado de los objetos.

- Creación de los materiales.

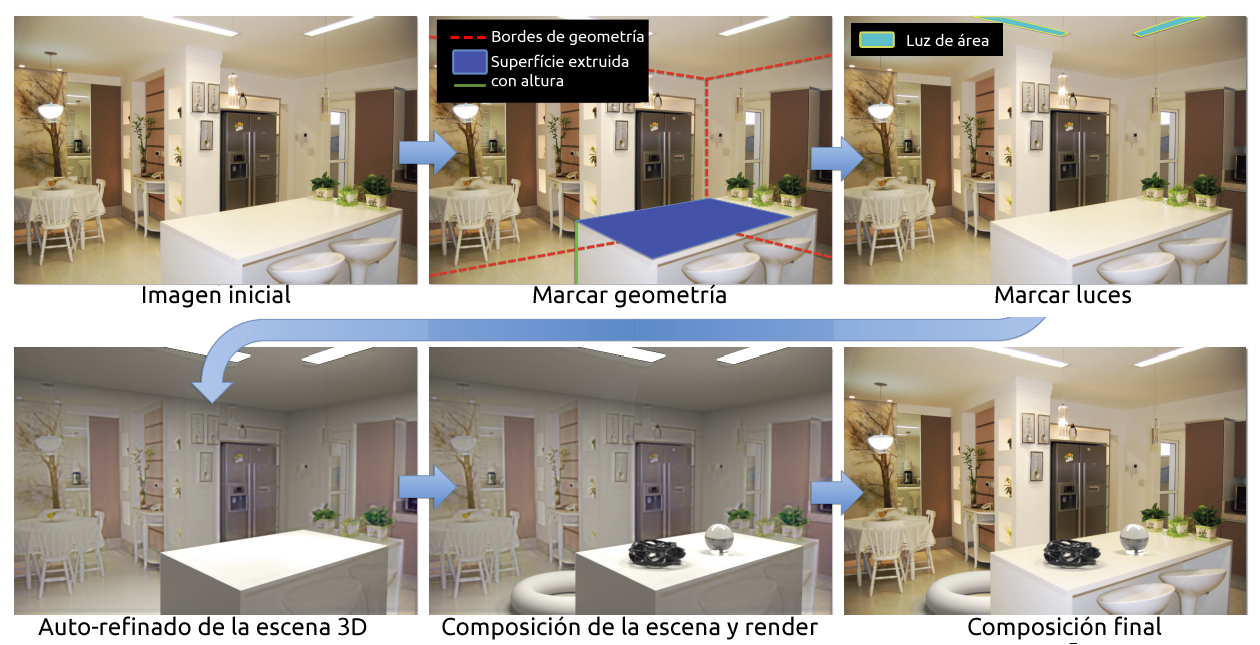

Con el método que ellos proponen todas éstas tareas quedan mucho más reducidas, con lo que se gana en tiempo, que es esencial en un trabajo productivo. Para empezar nos sirve cualquier fotografía. En cuanto al modelado, hoy en día no existen técnicas suficientemente precisas y automatizadas para obtener de una imagen 2D toda la información de la imagen: distancias, tamaños, etc. Ellos lo resuelven con un sistema de guías que podemos ajustar en la imagen en los 3 ejes. Al menos conseguimos una posición y tamaño relativos para incluir cualquier geometría. Después posicionan el lugar de los puntos de luz: ventanas, lámparas, etc. Pues bien, con tan solamente ésta información ya se puede obtener la escena en 3D, con un modelo de luz física, materiales para las superfícies y los parámetros de la cámara.

El tiempo estimado en éste workflow es de tan solo uno o dos minutos. ¡Muy rápido!

A continuación os dejo un vídeo demostrativo y el enlace a su página.

Enlace: Kevin Karsch